杀疯了!一夜之间,全球最强端侧多模态模型再次刷新,仅用8B参数,击败了多模态巨无霸Gemini Pro、GPT-4V。而且,其OCR长难图识别刷新SOTA,图像编码速度暴涨150倍。这是国产头部大模型公司献给开发者们最浪漫的520礼物。

拳打GPT-4V,脚踢Gemini Pro,仅仅8B参数就能击败多模态大模型王者。

今天,这个全球最强端侧多模态模型彻底「杀疯了」!

众所周知,端侧模型是AI发展的大趋势——从微软、谷歌再到苹果和英特尔,全球科技巨头都在争抢在PC和手机等端侧场景的AI落地。

但万万没想到的是,端侧模型的性能竟然可以这么猛,进化速度竟然可以这么快!

更令人惊喜的是,它不是来自国外大厂,而是出自国内大模型研发实力最头部的公司面壁智能——他们最新打造了面壁小钢炮MiniCPM-Llama3-V 2.5。

而且,选择在今天520这个特殊的日子推出,据说是送给开源社区的情人节礼物,简直浪漫的不像个科技公司~

MiniCPM-Llama3-V 2.5开源地址:

https://github.com/OpenBMB/MiniCPM-V

MiniCPM系列开源地址:

https://github.com/OpenBMB/MiniCPM

Hugging Face下载地址:

https://huggingface.co/openbmb/MiniCPM-Llama3-V-2_5

那么这个小钢炮究竟有多强?何以能担当得起全球最强端侧多模态模型的称号?

总结来讲,MiniCPM-Llama3-V 2.5不仅支持30+多种语言,而且还具备:

最强端侧多模态综合性能:超越多模态巨无霸Gemini Pro、GPT-4V;

OCR能力SOTA!9倍像素更清晰,难图长图长文本精准识别;

图像编码快150倍!首次端侧系统级多模态加速。

下面这张图反映了在全球范围内,小参数、高性能的多模态大模型已经成为趋势;

而其中最亮眼的一颗星正是面壁小钢炮MiniCPM-Llama3-V 2.5。

MiniCPM-Llama3-V 2.5用实力证明了——模型不是只有「参数越大才能性能越好」,而是可以用最小参数撬动最强性能!

另外随着大模型参数愈益降低、端侧算力愈益增强,高性能端侧模型势头强劲。

而手机、PC等智能终端设备因其高频的影像视觉处理需求,对在端侧部署AI模型提出了更高的多模态识别与推理能力要求。

从面壁「小钢炮」三月三级跳的迅猛进化来看,推动推理成本大幅降低、大模型高效落地,胜利在望。

OCR能力SOTA+最强端侧多模态

8B端侧模型,超越GPT-4V、Gemini Pro

这一次,MiniCPM-Llama3-V 2.5以8B端侧模型参数量级,贡献了惊艳的 OCR(光学字符识别)SOTA成绩,以及端侧模型中的最佳多模态综合成绩与幻觉能力水平。

模型雷达图,MiniCPM-Llama3-V 2.5综合能力水平全面优秀

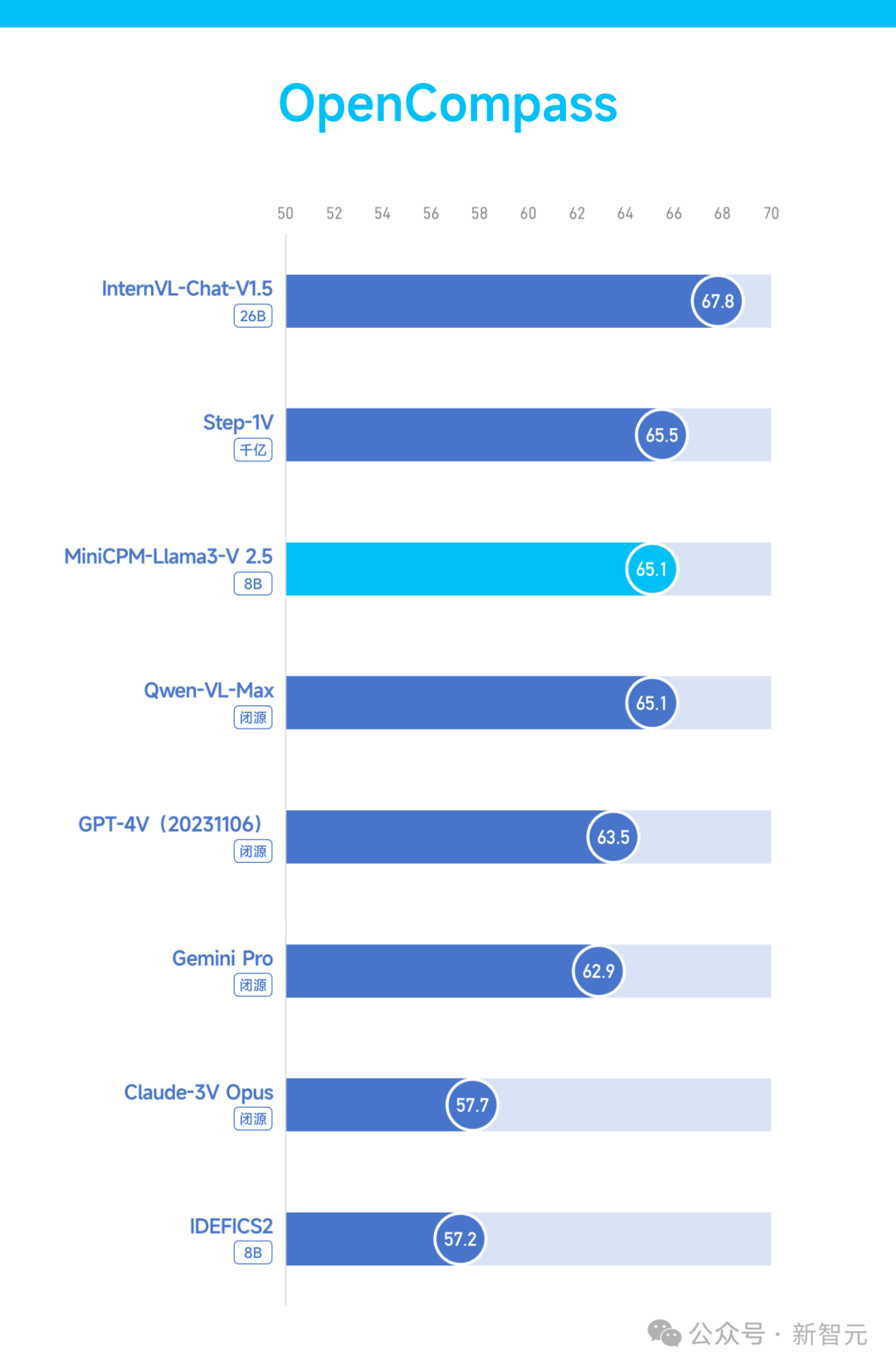

在综合评测权威平台OpenCompass上,MiniCPM-Llama3-V 2.5以小博大,综合性能超越多模态巨无霸GPT-4V和Gemini Pro。

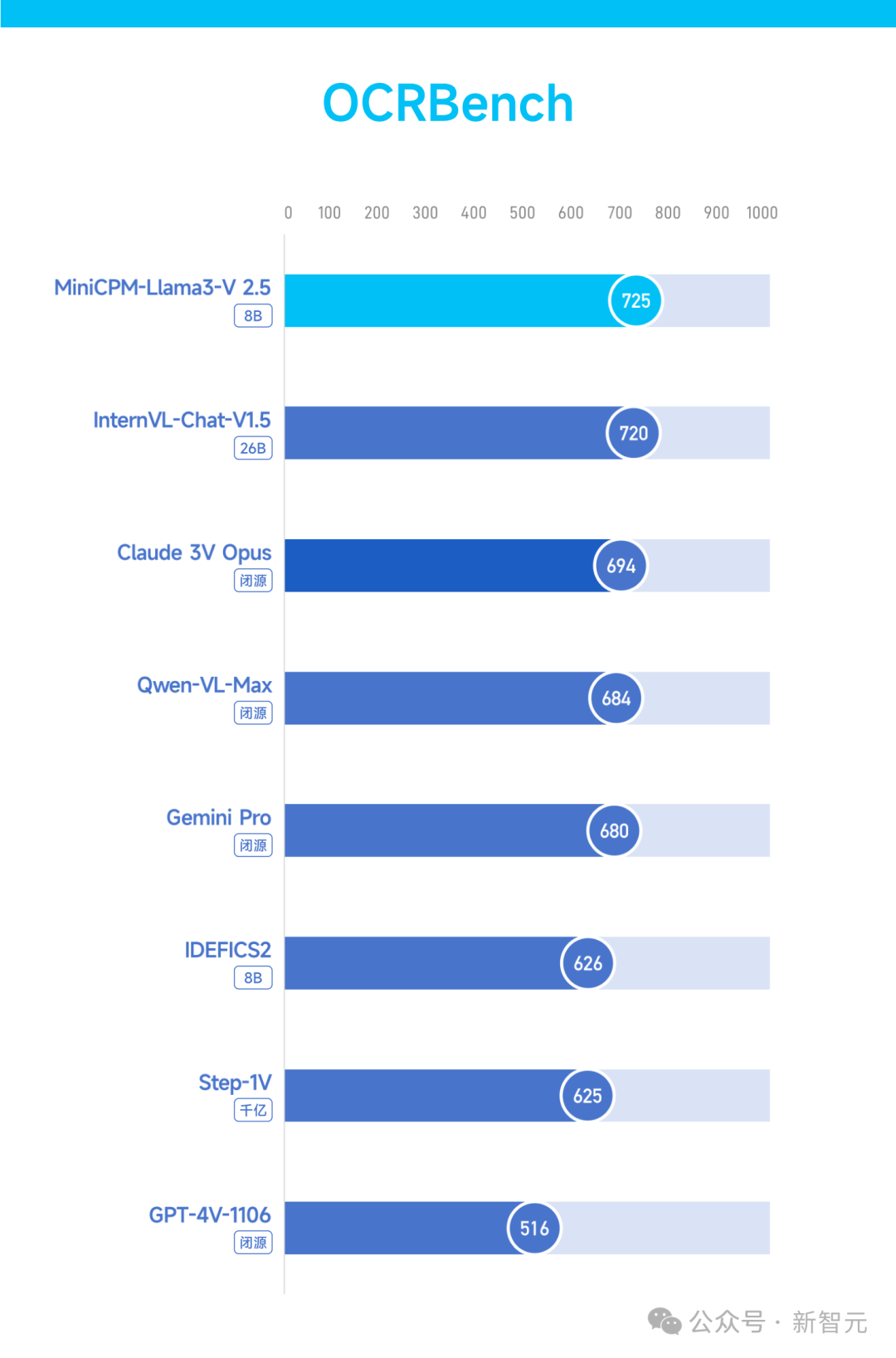

OCR(光学字符识别)是多模态大模型最重要的能力之一,也是考察多模态识别与推理能力的硬核指标。

新一代MiniCPM-Llama3-V 2.5 在OCR综合能⼒权威榜单OCRBench上,越级超越了Claude 3V Opus、Gemini Pro等标杆模型,实现了性能SOTA。

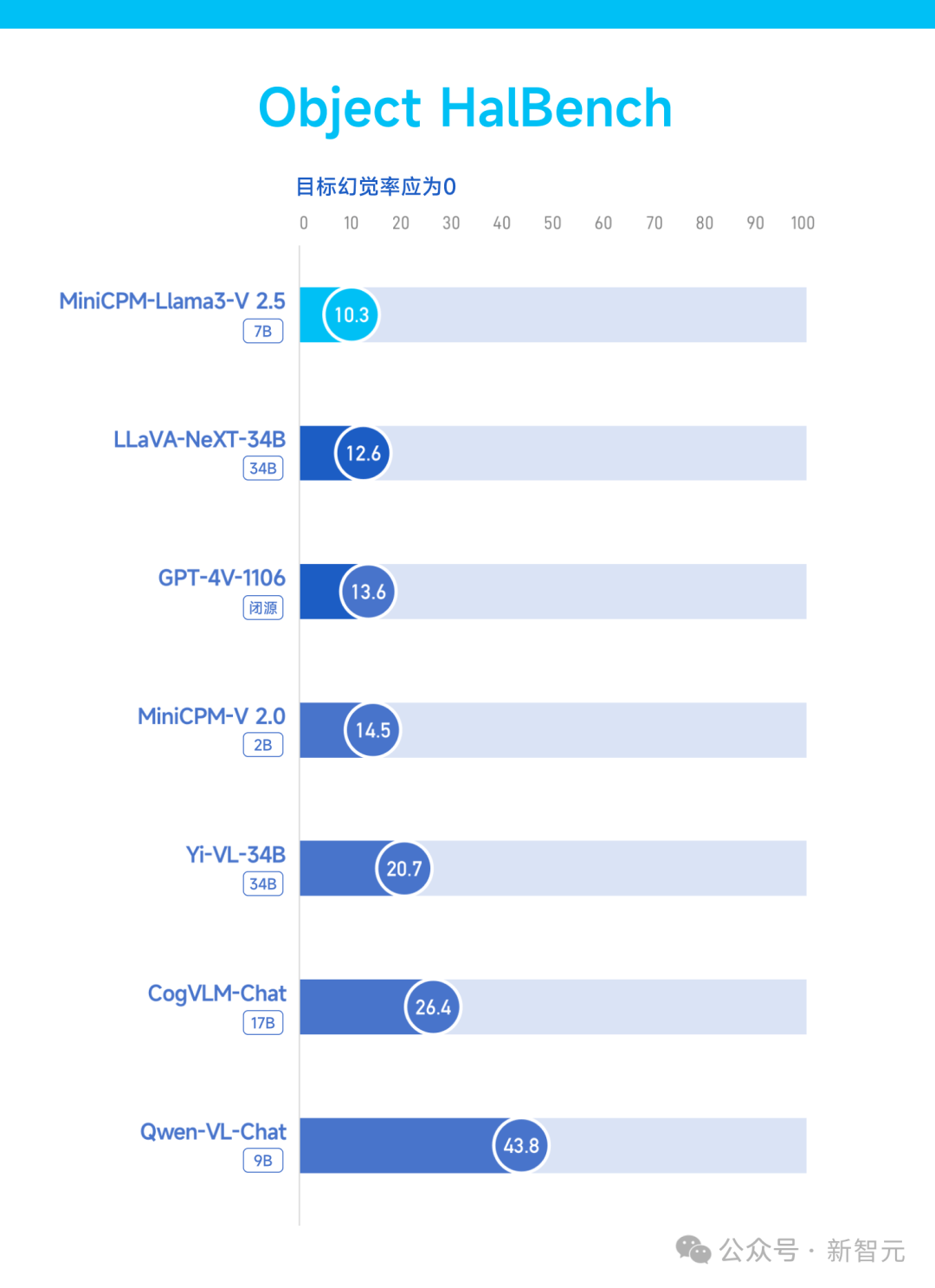

在评估多模态大模型性能可靠性的重要指标——幻觉能力上,MiniCPM-Llama3-V 2.5在Object HalBench榜单上超越了GPT-4V等众多模型(注:目标幻觉率应为0)。

在评估多模态模型的基本现实世界空间理解能力的RealWorldQA榜单上,MiniCPM-Llama3-V 2.5再次超越GPT-4V和Gemini Pro,这对8B模型而言难能可贵。

快150倍!首次端侧系统级加速

支持30+多语言,拥抱世界开源社区

首次进行端侧系统级加速,MiniCPM-Llama3-V 2.5已高效部署手机。

在图像编码方面,面壁首次整合NPU和CPU加速框架,在MiniCPM-Llama3-V 2.5图像编码方面实现了150倍加速提升。

在语言模型推理方面,目前开源社区的报告结果显示,Llama 3语言模型在手机端侧的解码速度在0.5 token/s上下,相比之下,多模态大模型的端侧运行面临着更大的效率挑战,经过CPU、编译优化、显存管理等优化方式,面壁将 MiniCPM-Llama3-V 2.5在手机端的语言解码速度提升到3-4 token/s。

目前,语言模型的图像编码加速也在进行中,更灵敏互动体验即将到来。

(此处GIF为2倍速演示,面壁正进一步加速优化中)

(此处GIF为2倍速演示,面壁正进一步加速优化中)

有别于常见的中英双语模型,MiniCPM-Llama3-V2.5可支持30+多种语言,

包括德语、法语、西班牙语、意大利语、俄语等主流语言,基本覆盖一带一路国家。

基于自研的跨语言泛化技术,仅通过少量翻译的多模态数据的指令微调,就可对多语言多模态对话性能高效泛化。

现在,上百个国家的几十亿人口,终于可以自如使用母语和端侧大模型交流,不再游离于前沿科技发展的主线,也因此享有更多AI应用落地、生活品质提升与参与科技角逐的可能性。真正让更多人享受大模型的乐趣!

多语言案例展示(语言加速工作正在进行,此处为2倍速)

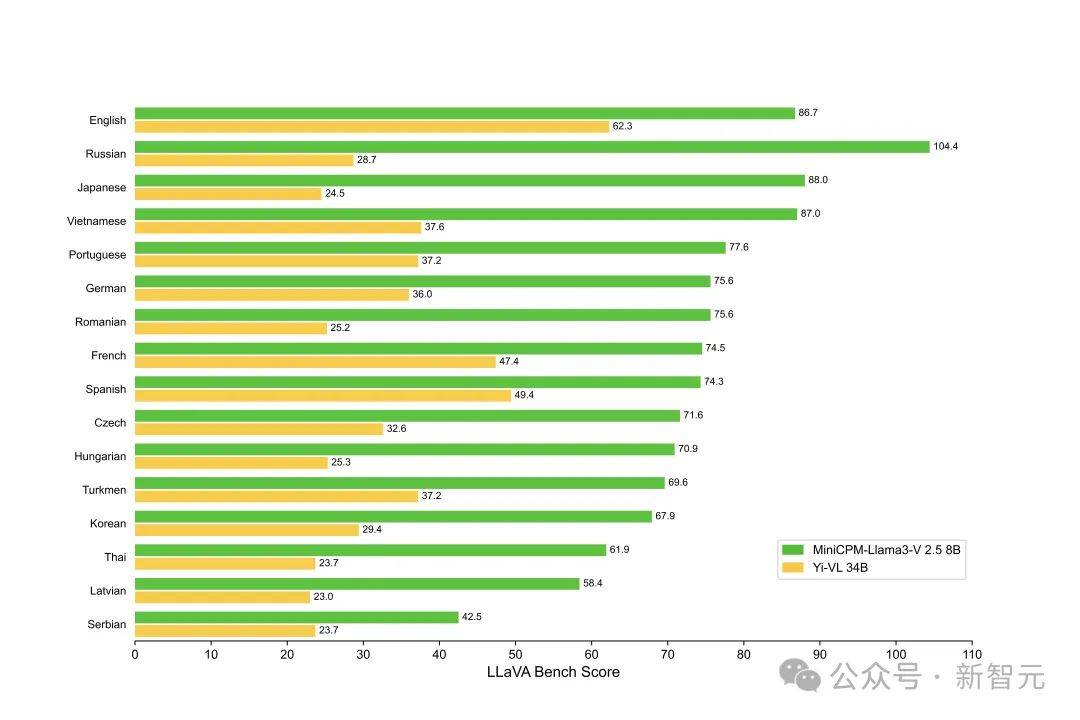

多语言版本LLaVABench评测结果,MiniCPM-Llama3-V 2.5对话能力更胜一筹

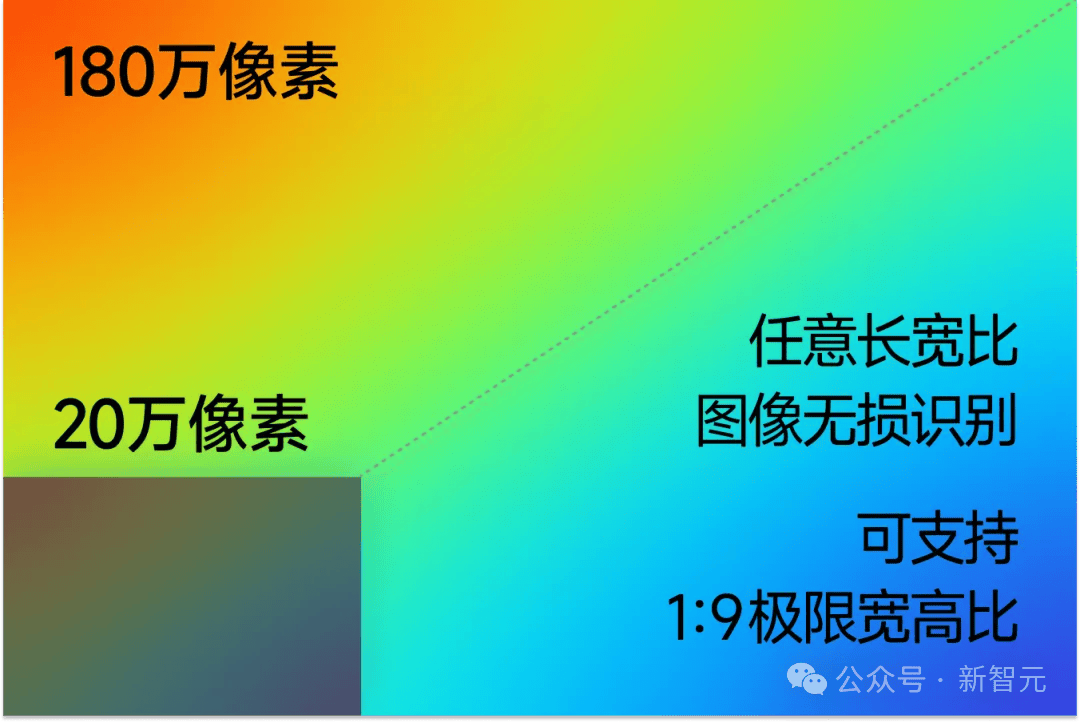

9倍像素更清晰

难图长图长文本精准识别

OCR技术进一步打磨,复杂推理与多模态识别能力再进化,MiniCPM-Llama3-V 2.5对于难图、长图、长文本的精准识别,再度带来出众表现!

面壁自研高清图像高效编码技术,可以高效编码及无损识别180万高清像素图片,并且支持任意长宽比、甚至「有点变态」的1:9极限比例图像,突破了传统技术仅能识别20万像素小图的瓶颈。

此前,MiniCPM-V系列多模态模型就因对于街景、长图等困难场景的高效解析,赢得了良好口碑。

技术升级,MiniCPM-Llama3-V 2.5在复杂推理能力上进一步突破。可更好地深入洞察图像,在更复杂、更接近人类的水平上进行思考和解决问题,堪称大模型中的「小福尔摩斯」。

复杂推理能力使得模型不仅能理解单的文本或图像等模态信息,还能跨越不同模态间的综合信息,做出更准确和深入的分析。

比如给定一张充满繁密字迹的建筑风景图,难以人眼辨别,但MiniCPM-Llama3-V 2.5能够一眼看懂其中的《三体》主题,还能正确推理出这些建筑是为了纪念《三体》及其对中国科幻文学的贡献而设计,令人会心一笑。

把同样的问题抛给GPT-4V,结果并不理想。

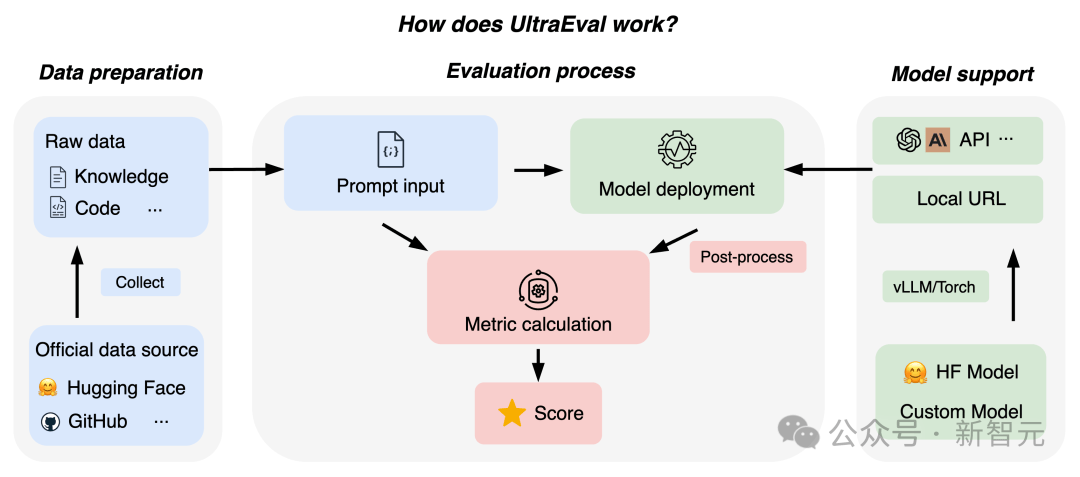

另外,识别包含复杂逻辑的流程图是多模态模型推理能力的直观体现,MiniCPM-Llama3-V 2.5不仅能够轻松看懂流程图中不同模块的文字、箭头之间的空间位置和复杂逻辑关系,还能给出清晰易懂的解释说明。

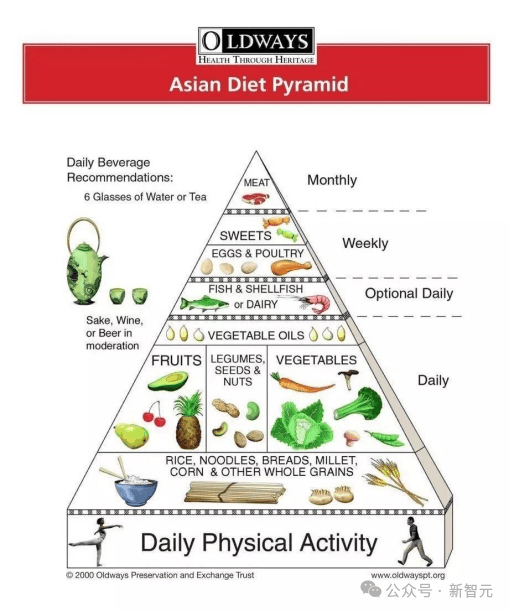

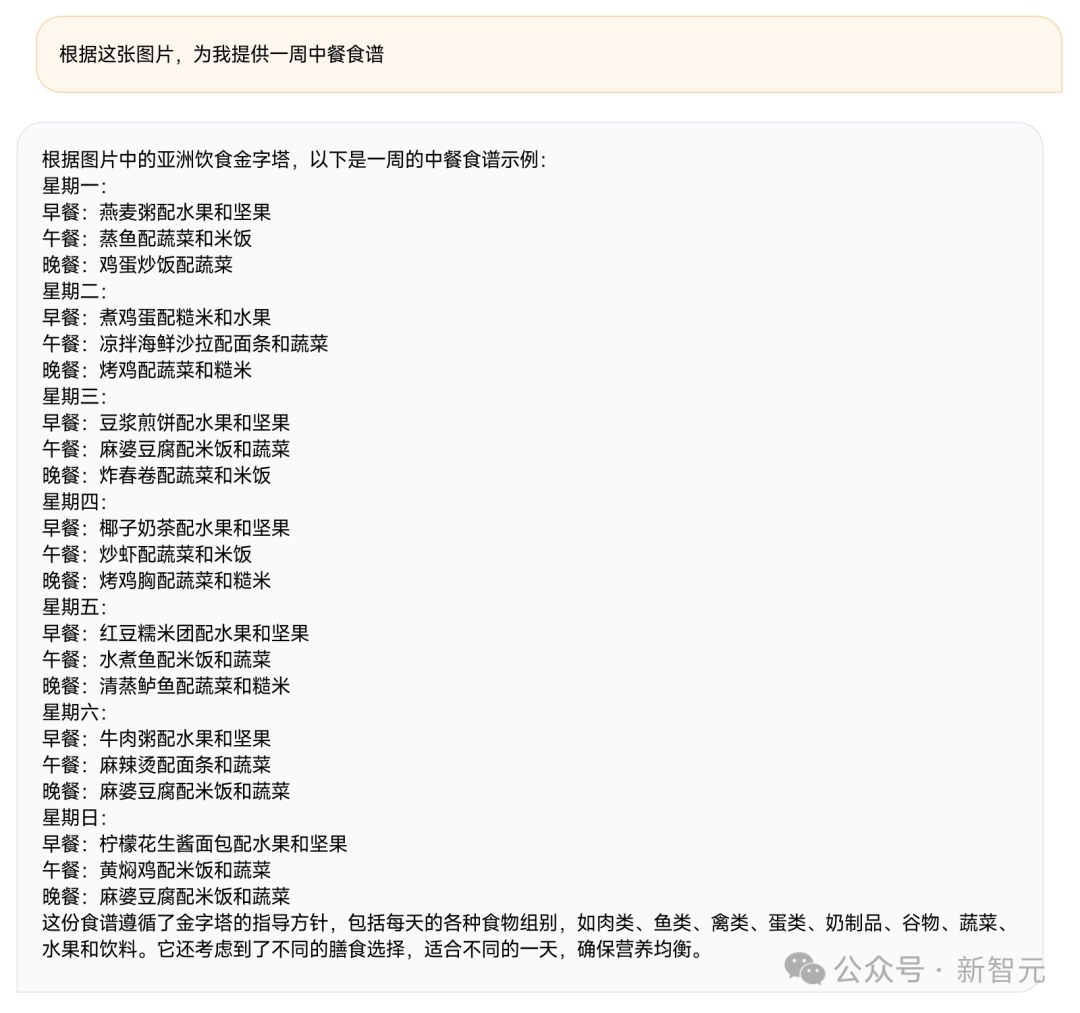

给妈妈转发一张亚洲饮食金字塔图,但她读不懂英文?

MiniCPM-Llama3-V 2.5凭借出色的推理能力,不仅深入理解分析图像里的饮食类型和分布,还能洞察背后的营养均衡需求,进行智能化搭配组合,直接一次性用中文推荐出满满一周的三餐食谱。

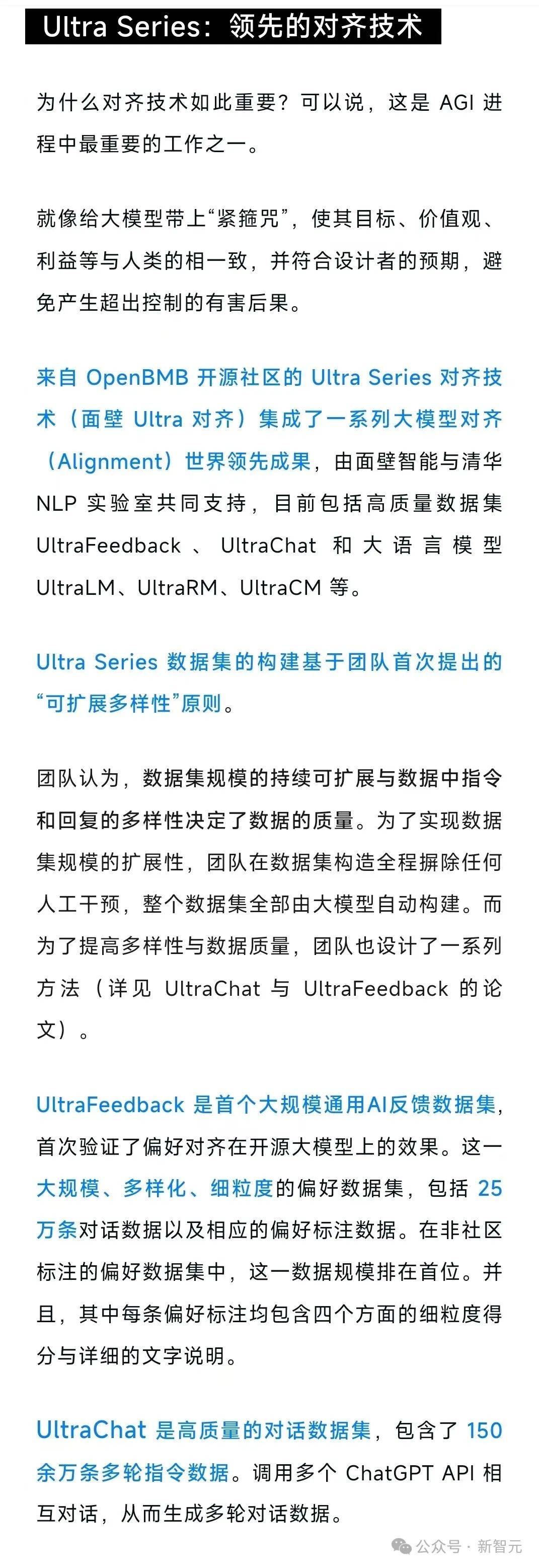

全文OCR能力方面,结构化信息提取能力的提升,对于长图长文本的精准识别大有帮助。

例如输入一张包含稠密信息的长文长图,MiniCPM-Llama3-V 2.5一字不差地识别出了全文。

上下滑动查看

再给一张要翻阅好几屏的图文复杂交错的长图难图长文本,MiniCPM-Llama3-V 2.5 也能精准给出正确的回答。

上下滑动查看

再输入一张手机拍摄的火车票,MiniCPM-Llama3-V 2.5 也能准确提取信息,给出无误的「json」格式输出。

最后,面壁是开源社区的热心贡献者,也是受益者。

本次MiniCPM-Llama3-V 2.5的飞跃表现依托于面壁团队对多模态技术的创新打磨,更离不开Llama3-8B-Instruct作为基座模型的性能基础。

感谢世界优秀同行的卓越工作,令我们站在彼此的肩膀上,伸手摘星,指向更高、更璀璨的科学无垠之处。

我们也将持续回报社区,开源更多优秀模型、数据、infra工具等,将开源开放的星火播撒世界协作创新之苍穹。

产品与服务

产品与服务

联系站长

联系站长

关于我们

关于我们